- Portfolio

-

Medien

- Medien

- Softeq-News

- Blog

- Häufig gestellte Fragen

- Entwicklung von IoT-Lösungen

- Digitale Transformation

- Entwicklung von Embedded Lösungen

- Hardwaredesign

- Venture Studio

- Kontakt

- ADAS-Lösung für Elektrofahrzeuge

- Mobile App, Web und Firmware für ein intelligentes Babybett

- PCB-Designverifizierung für ein automobiles Radarsensorsystem

- Gerätemanagement-Suite für smarte Thermostate und Raumluftqualität-Sensoren von Daikin

Edge Computing und KI: Echtzeit-Insights aus Rohdaten durch smarte Algorithmen

Künstliche Intelligenz (KI) und die Cloud-basierten IoT-Lösungen gingen schon immer Hand in Hand. Die Cloud stellt Ressourcen für das Daten-Training komplexer IoT-Systeme bereit. Und die KI-Technologie wiederum aktiviert verfeinert und aktualisiert Algorithmen, die die Autonomie der vernetzten Lösungen optimieren.

Inhaltsverzeichnis

Die Datenübertragung in die Cloud ist allerdings nicht mehr die allerneuste Technologie in der IoT-Softwareentwicklung. Es gibt kritische Probleme: unkontrollierte Latenzzeiten, instabile Netzwerkverbindungen und die geringe Zuverlässigkeit des Gesamtsystems. Um diese Risiken zu minimieren, kann die Verlagerung von KI-relevanten Operationen an die jeweilige Datenquelle, d. h. an den Edge (Rand) eines Netzwerks, eine gute Lösung darstellen. Und zwar eine so gute, dass Google, Apple und Amazon derzeit viele Millionen in Edge-Computing investieren, damit ihre Produkte schnell auf die eingehenden Anfragen reagieren können.

Einer der aktuellsten Trends im Internet of Things ist also eine dezentralisierte Netzwerkarchitektur mit Edge Computing, bei dem die Daten so nah wie möglich an der Datenquelle verarbeitet werden.

Wie funktionieren Edge-Computing und KI zusammen? Was sind potenzielle Anwendungsfälle für Unternehmen und welche Vorteile bringt diese Kombination? Und nicht zuletzt: Wie kann man mit Edge AI loslegen?

Edge AI: Wie funktioniert das?

Dank einer Kombination aus Edge-Computing und KI-Technologien (Edge AI) können Entwickler Daten, die von Geräten lokal oder auf dem Server in ihrer Nähe erstellt werden, mit KI-Algorithmen verarbeiten. So treffen die Geräte Entscheidungen in wenigen Millisekunden, ohne sich mit der Cloud verbinden oder Daten an andere Network Edges übertragen zu müssen.

Was unterscheidet Edge AI von typischem Cloud Computing?

Ein KI-Modell wird in der Regel auf einem geeigneten Datensatz trainiert, um bestimmte Aufgaben auszuführen. Schritt für Schritt lernt das Modell, ähnliche Muster in anderen Datensätzen mit ähnlichen Charakteristiken zu finden.

Sobald es in einer unbekannten Umgebung gut genug funktioniert und die gewünschte Leistung erbringt, wird das Modell in der Praxis eingesetzt. Es erstellt Prognosen, gibt diese an andere Softwarekomponenten weiter oder visualisiert sie auf einer Frontend-Schnittstelle für Endbenutzer.

Mit der Cloud können Entwickler Technologien der Künstlichen Intelligenz in großem Maßstab nutzen. Das Training eines Modells erfordert enorme Rechen- und Datenspeicher-Ressourcen und die Cloud wird zu einer natürlichen Lösung. Die Cloud hat KI in den Mainstream gebracht — aber jetzt stellt sie die weitere Entwicklung der Technologie vor große Herausforderungen.

Warum schränkt die Cloud das KI-Potenzial ein?

Im Kontext von Industrie 4.0 wächst der Bedarf an Echtzeit-Computing rasant — und die Cloud kann ihn nicht mehr decken.

Die eigentliche Idee der Cloud wird mit der sich ständig verändernden digitalen Umgebung inkompatibel. Die benötigten Daten werden zunächst in die Cloud übertragen, wo sie nach dem vorgegebenen Modell verarbeitet und erst dann zurück an das Endgerät übermittelt werden. Dabei können zahlreiche Herausforderungen entstehen:

- Unzuverlässige Verbindung. Was ist, wenn ein Datentransfer zu langsam oder gar unmöglich ist?

- Latenzzeit. Während die Daten hin und her übertragen werden, können unternehmenskritische Anwendungen die anstehenden Probleme nicht bewältigen.

- Sicherheits- und Datenschutzbedenken. Jeder Angriff auf sensible medizinische, finanzielle, persönliche und andere Daten in der Cloud kann für Unternehmen fatal enden. Eine ständig wachsende Zahl von Sicherheitsrisiken im Zusammenhang mit der Cloud muss im Auge behalten werden.

- Hohe Kosten für Bandbreite. Verarbeitung großer Datenmengen in der Cloud, wie bei GPU-Computing, ist ziemlich teuer, da man viel Speicherkapazität von einem Cloud-Dienst kaufen muss. Zusätzliche Bandbreite für schnelle Antwortzeiten erfordert auch erhebliche Investitionen.

Das sind nur einige Aspekte, bei denen Spezialisten im Bereich KI-Technologien und Cloud-Infrastrukturen ihre Bedenken haben.

"Kosten, Leistung, Workload-Management und Datenzugriff. All dies sind Herausforderungen, denen sich Datenwissenschaftler bei ihrer Arbeit in der Cloud stellen müssen."

Bret Greenstein, Vizepräsident und Global Head of Artificial Intelligence bei Cognizant

Wie hilft Edge AI, die Herausforderungen zu bewältigen?

Stellen Sie sich nun eine smarte Fabrik vor, in der Spezialisten vernetzte Handgeräte für den täglichen Betrieb verwenden. Die Geräte sammeln, verarbeiten und analysieren Daten in Echtzeit. Sie stellen bei Bedarf die erforderlichen Informationen bereit und senden in Notfällen sofortige Benachrichtigungen. Am Ende eines Arbeitstages übertragen sie die Daten in die Cloud: zur tieferen Analyse und für andere Prozesse, wie vorausschauende Wartung oder weitere Produktentwicklung.

Dies ist möglich, weil die Datenverarbeitung lokal am Edge erfolgt: Ein konsolidierter Datensatz wird zum Training eines Modells verwendet, das lernt, Entscheidungen zu treffen, zu agieren und anderes selbstständig zu tun. KI-basierte Techniken ermöglichen die Automatisierung komplexer Entscheidungen direkt am Edge für schnellere, vertrauliche und kontextbezogene Anwendungen.

Edge AI: Wie funktioniert das unter der Haube?

"Edge AI wird eingesetzt, wenn KI-Techniken in Internet of Things ( IoT)-Endpunkte, Gateways und andere Geräte am Ort der Nutzung eingebettet werden."

Jason Mann, Vizepräsident für IoT bei SAS

Eine immer größere Zahl der Edge Devices — Sensoren, Mobiltelefone, Edge-Knoten — erfordert eine Verlagerung von Netzwerken (Cloud-Rechenzentren) zum Netzwerkrand, um riesige Datenmengen in der Nähe zu verarbeiten.

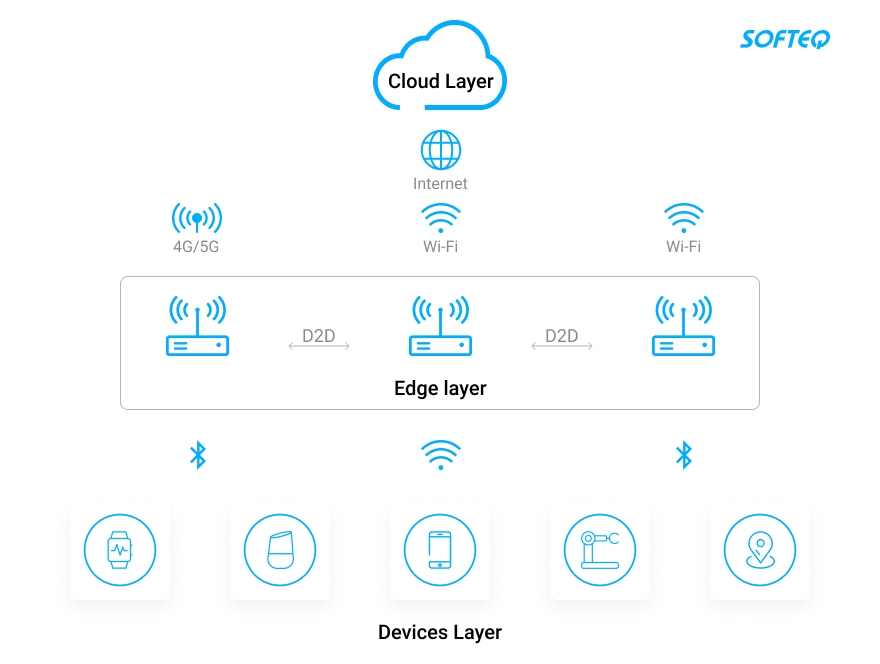

In einer Edge-Computing-Architektur erfolgt Datenverarbeitung auf Geräten (Endknoten) und an Gateways (Edge-Knoten).

Edge AI wird typischerweise in einem hybriden Modus eingesetzt, der den dezentralisierten Trainingsmodus "am Edge" mit einem zentralisierten überarbeiteten Modus kombiniert, wo die Algorithmen überarbeitet und aktualisiert werden.

- Die Knoten auf der oberen Ebene fungieren als einfache Sammler von Daten, die von Sensoren und Aggregatoren erstellt werden. Später werden diese Daten für Trainingszwecke verwendet.

- Machine-Learning (ML)-Algorithmen werden lokal auf Endknoten und eingebetteten Systemen ausgeführt, im Gegensatz zu entfernten Cloud-basierten Servern. Aktivierungswörter oder -phrasen wie "Alexa" oder "OK Google" sind zum Beispiel einfache ML-Modelle, die lokal auf dem Lautsprecher gespeichert werden. Immer wenn der Smart Speaker das Aktivierungswort oder die -phrase hört, beginnt er mit dem "Zuhören", d.h. mit dem Streaming von Audiodaten an einen entfernten Server, wo er die vollständige Anfrage bearbeiten kann.

- Modellaktualisierungen werden in die Cloud zurückgeschickt, die sie aggregiert und das verbesserte Modell an die Endgeräte zurückschickt.

In einer Architektur, wo KI-Algorithmen mit Edge Computing kombiniert werden, erreichen wir eine geringere Übertragungslatenz, einen höheren Datenschutz und reduzierte Bandbreitenkosten. Dies erhöht jedoch die Rechenlatenz und den Energieverbrauch.

Deshalb ist die Verteilung zwischen dem KI-Computing am Edge und dem in der Cloud flexibel und von der Anwendung abhängig. Bei der Wahl des Levels der Edge-Intelligenz muss man mehrere Faktoren berücksichtigen: Latenz, Energieeffizienz, Datenschutz und Bandbreite-Kosten.

Smarte Algorithmen lokal einsetzen: Erfolgreiche Anwendungsfälle

Produktion: Präzisionsüberwachung und Maschinensteuerung

Fabrikarbeiter müssen sich in Echtzeit mit unzähligen Fertigungsprozessen auseinandersetzen: Gerätebewegungen optimieren, Temperatur reduzieren, Schwingungen kontrollieren und so weiter. Unter diesen Bedingungen muss die Latenzzeit minimiert werden, und Edge AI trägt dazu bei, Datenverarbeitung näher an die Fertigungsanlage heranzuführen und die Gesamtanlageneffektivität (GAE) zu verbessern.

Mit Edge AI können Betreiber das Gerät in der tatsächlichen Umgebung und unter realen Bedingungen trainieren: Liniengeschwindigkeit, Arbeitsstil, Umgebungstemperatur und -feuchtigkeit usw.

Daihen Corp., ein japanisches Unternehmen für Industrieelektronik, ist ein gutes Beispiel für eine effektive Implementierung der Edge KI. Es wollte die Daten von vielen Geräten, die den Materialzustand bewerten, analysieren, und den Bedarf an manueller Überwachung reduzieren. Das Unternehmen verwendet Machine-Learning-Modelle auf seinen stark eingeschränkten Geräten und es gelingt ihm, Überwachung und Steuerung des gesamten Herstellungsprozesses von industriellen Transformatoren zu automatisieren.

Außerdem installierten sie neue Sensoren mit Edge AI-Algorithmen. Die Sensoren generieren in Echtzeit Daten über alle Teile der elektrischen Transformatoren: wie sie zusammengebaut und gelagert werden. Sie verfolgen auch, wie lange jede Etappe dauert, und geben Aufschluss über alle Änderungen, die sich auf die Qualität der produzierten Komponenten auswirken könnten.

Transport: Höhere Sicherheit und schnellere Reaktion

McLaren Racing ist ein Teil der McLaren Group, die mit Grand-Prix-Rennen und Weltmeisterschaften arbeitet. Jeder Formel-1-Rennwagen ist mit mehr als 200 Sensoren ausgestattet, die an einem Rennwochenende 100 Gigabyte Daten produzieren und mehr als 100.000 Datenpunkte pro Sekunde übertragen.

Um ein Rennen zu gewinnen und Sicherheit des Teams zu gewährleisten, benötigen Ingenieure und Crew-Mitglieder von McLaren sofortigen Echtzeit-Zugriff auf die generierten Daten. So können sie entscheiden, wann ein Reifen gewechselt werden muss, Sicherheit der Strecke bewerten usw. Es gibt keine Zeit zu warten, bis die Daten in die Cloud und zurück übertragen werden.

So hat McLaren Edge Computing und die Edge-Core-Cloud-Strategie eingeführt: Die Crew erhält verwertbare Daten in Echtzeit während eines Rennens, gleichzeitig werden dieselben Daten an das McLaren Technology Centre gesendet. Dort werden sie eingehend analysiert und in einen mit ML ausgestatteten Rennsimulator eingespeist, um die KI-Algorithmen zu verbessern und zu verfeinern.

Handel: Videoüberwachung, Gesichtserkennung und Flussanalyse

Edge AI in Videokameras kann zur Verfolgung der Kundenfrequenz und zur Analyse des Kaufverhaltens verwendet werden. NVIDIAs EGX AI-Plattform für Ladengeschäfte und Lager unterstützt Videoanalyse-Anwendungen, die Einkaufsstandorte digitalisieren, anonymes Käuferverhalten in Geschäften analysieren und Gestaltung der Ladenflächen optimieren.

Erste Schritte mit Edge AI

- Bereitschaft zum Edge Computing bewerten. Ohne eine ordnungsgemäß implementierte Edge-Lösung kann man nicht auf Edge AI wechseln. Erst wenn eine stabile Lösungsarchitektur vorhanden ist, die Edge Computing in Verbindung mit einem Cloud-Backend nutzt, kann KI integriert werden.

- Daten gründlich überprüfen. Da ein KI-Modell an Datensätzen trainiert wird, müssen die dafür verwendeten Daten vollständig und unvoreingenommen sein, die Datenverwaltung außerdem umfassend und effizient. Andernfalls erhält man falsche und sinnlose Antworten. Wenn es jedoch nicht genügend qualitativ hochwertige Daten gibt, um die Vorteile der KI zu nutzen, könnte man Daten durch die Geschäftslogik für datenbasiertes Lernen ersetzen.

- Flexible Enterprise-Architektur. Die Architektur mit Edge AI-Techniken muss erlauben, dass Modelle im Laufe der Zeit implementiert und aktualisiert werden. Sie muss außerdem neue Geräte- und Chipversionen, Betriebssystem-Modifikationen und Migration zu anderen Cloud-Anbietern unterstützen. Die entworfene Architektur muss von Geräten und der Cloud unabhängig sein und sich durch extreme Flexibilität auszeichnen.

- Datenspeicherung und Rechenleistung auf Edge-Level. Entwickler, die mit Cloud-Architekturen arbeiten, sind stark auf GPUs an zentralen Standorten angewiesen. Diejenigen, die Edge-Compute-Rollout-Strategien einsetzen, müssen hingegen eine praktikable Alternative zu den hochleistungsfähigen Rechenfunktionen der zentralisierten Cloud finden. Google zum Beispiel entwickelte seine eigenen TPUs, die für den Betrieb von AI am Edge ausgelegt sind.

Edge AI: Was ist zu beachten?

Obwohl Spezialisten Edge-Intelligenz nicht als vollwertigen Ersatz für Cloud Computing behandeln, entwickelt sich das System bereits zu einem wirksamen Instrument zur Förderung und Verbesserung von KI-Technologien in verschiedenen Bereichen. Das Hauptproblem bei der künstlichen Intelligenz ist die Latenz zwischen einem bestimmten Rechner und dem System als Ganzes. Edge Computing kann dieses Problem beseitigen, eine Anomalie korrigieren, sobald sie entdeckt wird, und sofortige Maßnahmen ergreifen.

- Das Interesse an Edge AI nimmt derzeit stark zu. Nach Angaben von Tractica LLC wird die weltweite Zahl der AI Edge-Geräte voraussichtlich von 161,4 Millionen im Jahr 2018 auf 2,6 Milliarden im Jahr 2025 ansteigen.

- Zu den Top-Geräten mit KI-Funktionalität gehören Mobiltelefone, Smart Speakers, PCs/Tablets, Head Mounted Displays, Automobilsysteme, Drohnen, Roboter und Sicherheitskameras.

- “Big Data, präzise Analysen und leistungsstärkere Hardware sind die drei großen Triebkräfte, die die KI aus der Cloud direkt zu den Endgeräten bringen und die Kombination von Edge Computing und KI fördern”, so P.K. Tseng, ein Analyst von TrendForce.

- Hardware und KI-Chips entwickeln sich rasch weiter und werden immer besser für Edge Computing geeignet. So unterstreichen Experten einen Trend zu eigenständigen Chips, die bestimmte Aufgaben wie Bildgebung oder Visualisierung übernehmen und im Vergleich zu energieintensiven GPUs eine relativ geringere Leistung aufweisen. Wie Fachleuten jedoch festgestellt haben, schränkt der Speicher nach wie vor die Kapazität des KI- und Machine Learning-Modells ein: ein fortschrittliches Modell erfordert mehr Rechenleistung und mehr Speicher.

- Die bisher größte Herausforderung betrifft die Fähigkeit von KI-Algorithmen, besser zu werden und ihre Präzision zu erhöhen.

Mehr Artikel zum Thema